faktenfinder

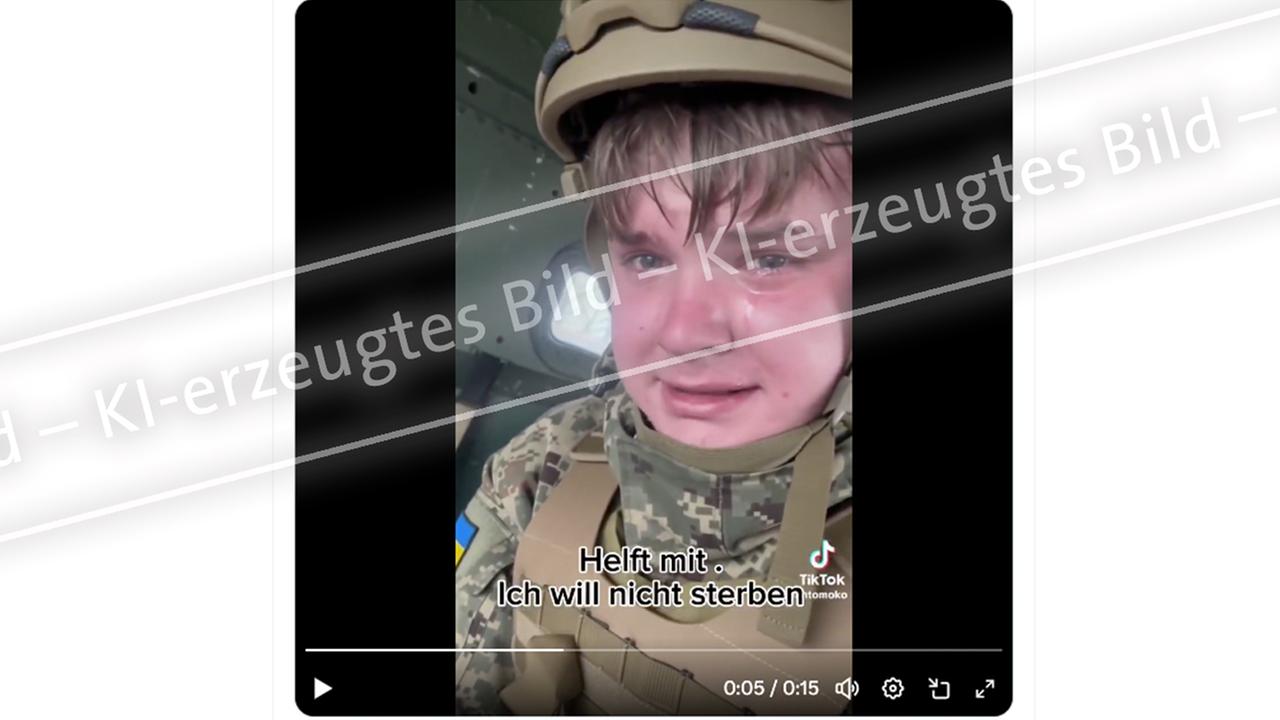

In einem emotionalen, viralen Video ist ein weinender ukrainischer Soldat zu sehen, der behauptet, erst 23 Jahre alt zu sein und zum Dienst an der Front gezwungen zu werden. Doch das Video ist eine KI-Fake.

“Helft mir, ich will nicht sterben”, fleht ein junger ukrainischer Soldat in einem 15-sekündigen viral gegangenen Video. Der Mann in Uniform schaut direkt in die Kamera und erzählt unter Tränen, er würde an die Front nach Tschassiw Jar geschickt werden. Er spricht ukrainisch und sagt, er sei erst 23 Jahre alt. Doch es ist nicht authentisch, sondern KI-generiert.

Das emotionale Video ist in den sozialen Medien hunderttausendfach in verschiedenen Sprachen geteilt worden. In Deutschland wird es unter anderem mit den Worten geteilt: “Mein Herz blutet bei den Worten des 23-jährigen ukrainischen Jungen, der verzweifelt sagt, er habe Angst und wolle nicht sterben.” Ein anderer Account schreibt: “Das Video ist allen deutschen Kriegsgeilen-Politikern gewidmet. An Merz und Co”.

Sachlich falsch

Nicht nur in Deutschland verbreitet sich das Video. Auch in anderen Ländern kursiert es mit Untertiteln in unterschiedlichen Sprachen, darunter Englisch, Französisch, Spanisch, Griechisch, Türkisch und Japanisch. Eine ungarische Version des Clips wurde mehr als 1,8 Millionen Mal aufgerufen.

Der angeblich wehrpflichtige Soldat gibt in dem Video an, 23 Jahre alt zu sein. Doch das Wehrpflichtalter in der Ukraine liegt derzeit zwischen 25 und 60 Jahren, Männer unter 25 Jahren können sich jedoch freiwillig melden. Im April des vergangenen Jahres wurde das Mindestalter von 27 auf 25 Jahre herabgesetzt, um angesichts des andauernden Kriegs mehr Soldaten mobilisieren zu können.

Mehrere Hinweise auf KI-Fälschung

Das Video ist nicht nur inhaltlich falsch, zahlreiche Hinweise sprechen dafür, dass es eine mithilfe von künstlicher Intelligenz erstellte Fälschung ist.

So erklären ukrainische Sprachexperten gegenüber der Verifikations-Einheit der Nachrichtenwebseite Euronews.com, dass die Aussprache von “Tschassiw Jar” nicht natürlich klinge und nicht mit der ukrainischen Muttersprache übereinstimme.

Laut Giorgio Patrini, CEO und Mitbegründerin von Sensity AI, einem Unternehmen, das KI-generierte Videos identifiziert und analysiert, weist der Helm des angeblichen Soldaten mehrere Auffälligkeiten im Vergleich zu echter Militärausrüstung auf. Die seitlichen Zubehörschienen und die Anordnung der Schrauben unterscheiden sich demnach deutlich von gängigen Modellen, zudem fehlen Klettverschlüsse, die bei echten Helmen üblich sind.

Die Analyse von Sensity ergab außerdem, dass die Aufnahmen mit Sora, dem Bildgenerator von OpenAI, erstellt und das ursprüngliche Wasserzeichen nachträglich entfernt wurden.

TikTok Account mit zahlreichen weiteren Videos

Dabei ist das Video nicht das einzige KI-generierte Video dieser Art. Ursprünglich lässt es sich zu einem inzwischen gelöschten TikTok-Profil zurückverfolgen. Dort finden sich Dutzende weitere Videos von vermeintlich weinenden jungen ukrainischen Soldaten, die in Militärfahrzeugen sitzen.

Auf einigen der Videos ist noch das Wasserzeichen von Sora zu sehen. Die meisten Videos haben ein paar tausend Aufrufe, einige erreichen jedoch Abrufzahlen von bis zu 2,1 Millionen Aufrufe.

Eine Gesichtserkennungssuche legt nahe, dass auf den Videos und hinter dem TikTok-Account der russische Streamer Wladimir Jurjewitsch Ivanov aus St. Petersburg steht, der unter dem Pseudonym Kussia88 bekannt ist.

Das Zentrum für Desinformationsbekämpfung, einer dem ukrainischen Nationalen Sicherheits- und Verteidigungsrat angegliederten Einrichtung, bestätigt, dass “das im Video gezeigte Gesicht einem russischen Staatsbürger, keinem Ukrainer” gehöre.

Hinter Kussia88 steht offenbar russischer Streamer

“Kussia” (ausgesprochen “kasha”) bedeutet auf Russisch (каша) “Haferbrei”. Aber die Verwendung von “88” (Neonazi-Code für “Heil Hitler”) und die lateinische Transkription mit einem doppelten “SS” sind wohl kein Zufall, wie Recherchen der “Deutschen Welle” (DW) zeigen.

Ebenso wenig wie die Verwendung der Buchstaben “IA”. In internationalen Neonazi-Kreisen wird “IA” als “14” verstanden – ein Code, der sich auf die “14 Wörter” bezieht, die vom amerikanischen Neonazi David Lane propagiert wurden: “Wir müssen die Existenz unseres Volkes und eine Zukunft für unsere weißen Kinder sichern.” Diese 14 Wörter sind weltweit für Neonazis zu einem vereinigenden Slogan geworden.

Tatsächlich erscheinen die Nummern 1488 und 8814 in der URL und Profilbeschreibung von Ivanovs Konten auf TikTok und Boosty (einer russischen Plattform, die es Content-Erstellern ermöglicht, durch Abonnements und Spenden von ihrer Community ein regelmäßiges Einkommen zu erzielen).

Laut mehreren Reddit-Chats wurde Ivanovs Twitch-Konto, das über 1,3 Millionen Follower hat, in den letzten Monaten mindestens einmal vorübergehend gesperrt.

Ob Ivanov die Videos tatsächlich erstellt hat und die Neonazi-Codes bewusst verwendet, ist unklar. Auf eine Anfrage der DW antwortete er nicht. Auf seinem Telegram-Kanal reagierte er jedoch sarkastisch auf Vermutungen, er sei an den KI-Videos beteiligt und ein “pro-Putin-Nazi”, indem er sagte: “Die Twitter-Gemeinde hat endlich gelernt, was ‘Delivery’ bedeutet” – ein russischer Twitch-Slangausdruck, der so viel bedeutet wie: “Sie sind endlich auf den Hype-Zug aufgesprungen.”

Auch Kritiker Putins auf Videos zu sehen

Ein weiteres Gesicht, das regelmäßig in Clips zu sehen ist, die von dem TikTok-Account gepostet werden, ist das von Alexej Gubanow, einem Kritiker des russischen Präsidenten Wladimir Putin. Gubanov, der heute in New York lebt, sagte der DW, er habe “absolut keine Verbindung” zu den Clips. “Alle wurden von jemandem mit Hilfe von KI und ohne meine Zustimmung oder Beteiligung erstellt.”

Er fügte hinzu, er habe sein Publikum gewarnt, “dass jemand absichtlich versucht, öffentliche Empörung zu schüren, indem er diese Art von Inhalten erstellt. Diese Videos spielen direkt in die russischen Propagandanarrative hinein und gewinnen Millionen von Aufrufen. Um es ganz klar zu sagen: Ich habe keines dieser Videos erstellt, genehmigt oder daran teilgenommen, und ich verurteile die Verwendung von KI-generierten gefälschten Medien zur Manipulation oder Propaganda aufs Schärfste.”

Hinweis: Dieser Artikel entstand im Rahmen der Kooperation der ARD Faktenchecker von ARD-faktenfinder, BR24 #Faktenfuchs und DW Fact check.